Ставим диагноз: действительно ли просели позиции

Первое, на что нужно обратить внимание:

Просел только наш сайт или вообще изменилась вся выдача

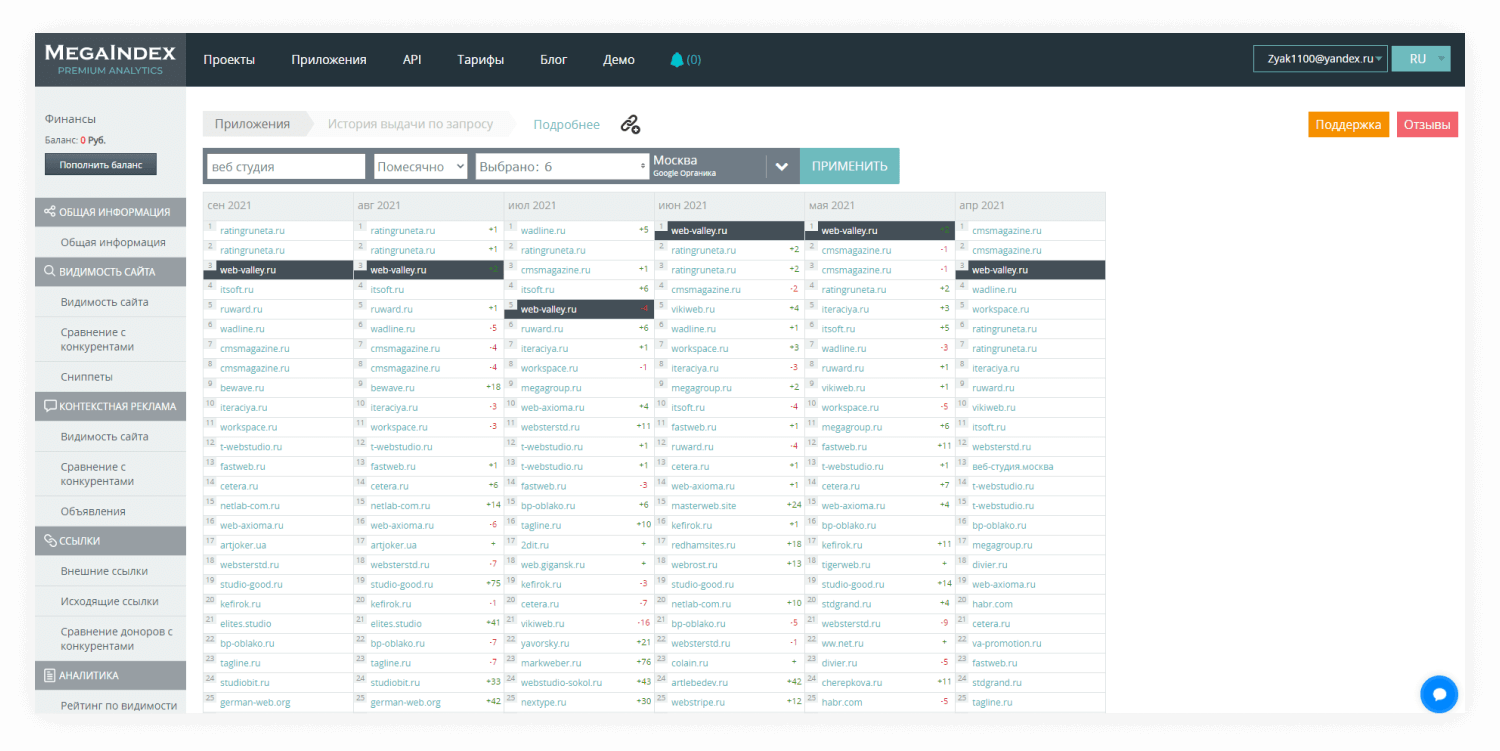

Сайты в ТОПе не прибиты гвоздиками, выдача подвижна. Недостаточно один раз выйти в ТОП и забыть — над сайтом придется работать постоянно. Но чтобы понимать, в какую сторону рыть, надо посмотреть, просел только ваш сайт (а значит, проблема в нем), или изменился весь состав ТОП-10 (тогда дело в смене алгоритма поисковой системы).

Для этого используют любые инструменты, которые умеют делать снимки выдачи. Например, в сервисе MegaIndex в левом вертикальном меню внизу есть инструмент «История по запросу». Вводим поисковый запрос, по которому хотим отследить изменения в выдаче, выбираем количество месяцев, поисковую систему и регион, нажимаем «Применить» и смотрим, как менялись наши позиции и конкурентов:

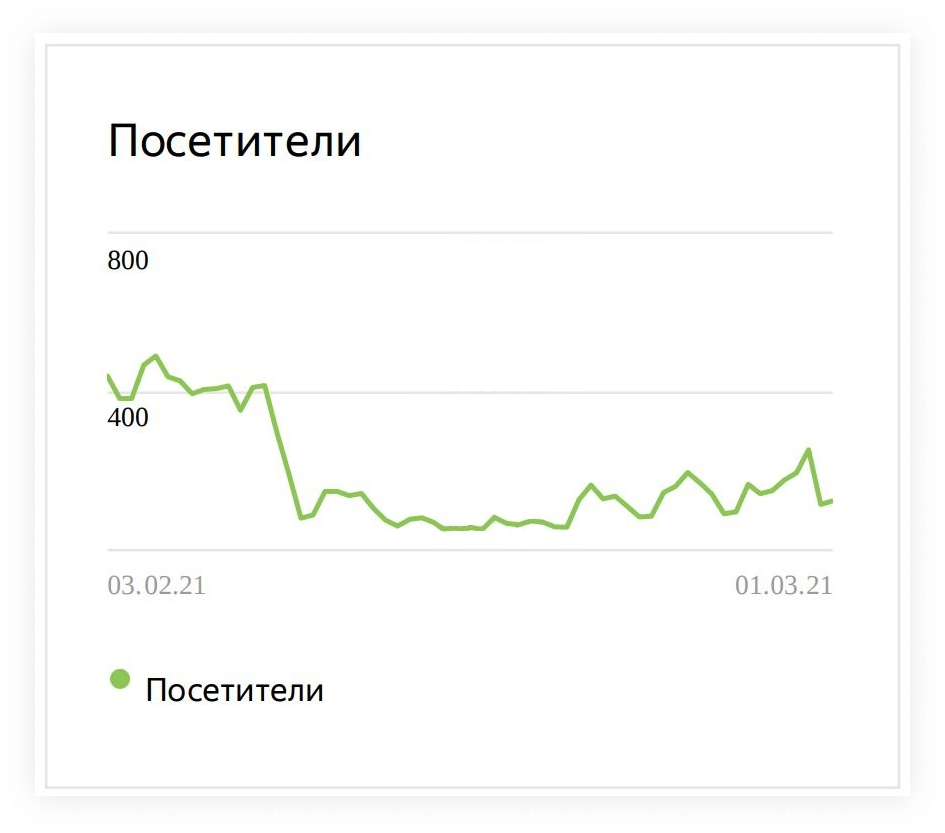

Падение позиций резкое и внезапное или плавное и затяжное

Определяем характер падения: если все произошло в момент — дело в смене алгоритма, попадании сайта под фильтр или технических неполадках, из-за которых сайт недоступен для робота:

Если же падение происходит медленно, но верно, то снижается качество сайта в сравнении с конкурентами: контент не обновляется или стал менее полезным, сократилось количество внешних ссылок ведущих на сайт, визуал и юзабилити перестали отвечать потребностям пользователей:

Упал весь сайт или отдельные страницы

Уронить весь сайт могут только фильтры поисковых систем и ошибки технической оптимизации (сайт скрыт от индексации, код ответа сервера отличный от 200 и т. д.). Если просели отдельные страницы, либо отдельные запросы — работаем точечно над каждой страницей, выявляем и исправляем неполадки.

Насколько серьезная просадка: в пределах ТОПа, вылет за пределы ТОПа, полная потеря видимости сайта

Чем ниже улетел сайт, тем серьезнее проблема и тем больше сил и времени потребуется, чтобы восстановить позиции. В следующем разделе рассмотрим, что делать в каждом конкретном случае.

Позиции упали в рамках ТОП-10

Сайт был в ТОП-5, а стал в ТОП-10. Вроде все еще на первой странице в выдаче, но вдруг так пойдет и дальше, и мы вообще вылетим за пределы ТОПа?

На самом деле переживать рано. Нужно сначала установить причину.

Конкуренция

Самая большая ошибка при продвижении сайта — думать, что конкуренты не занимаются сейчас тем же самым. Возможно, они даже ориентируются на ваш сайт, пытаясь понять, как улучшить контент на своем. Посмотрите, как конкуренты доработали свой сайт, чтобы получить высокие позиции: добавили описание к товару, отзывы, фильтры, сделали сайт удобнее для пользователя.

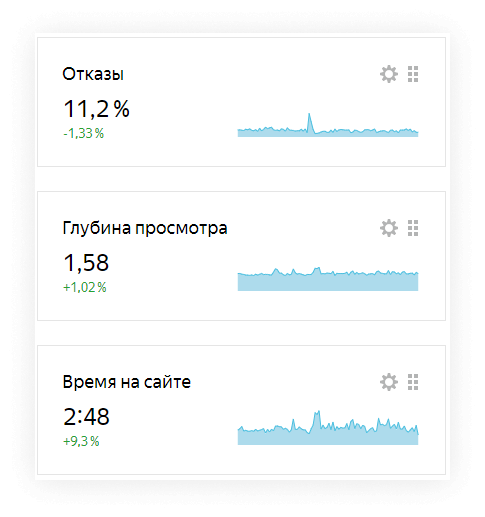

Поведенческий фактор

Поведенческий фактор — самая распространенная причина, по которой сайт мигрирует в рамках ТОП-10. Причем смена позиции может происходить ежедневно: сегодня на ваш сайт зашли 100 человек, и сразу вышли, просадив его позиции. Завтра зашли те же 100 человек, но они внимательно читали тексты, проводили на страницах много времени, активно взаимодействовали с контентом, как следствие — улучшили поведенческий фактор и сайт опять поднялся выше.

Поэтому позиции в ТОП-10 нужно анализировать не чаще, чем раз в месяц. Абсолютно нормально, что сайт каждый день немножко скользит в выдаче. А если у вас удобная навигация, продуманная перелинковка, приятный дизайн, красиво сверстанный текст и другие предпосылки к хорошему поведенческому фактору, то никаких действий дополнительно предпринимать не нужно.

Изменение структуры выдачи

В зависимости от интента запроса, выдача бывает информационная и коммерческая. Алгоритм поисковой системы работает так, что может поменять структуру выдачи, ориентируясь на поведение пользователей.

Например, у нас интернет-магазин стройматериалов. Наш сайт был в ТОПе по запросу «керамическая плитка» — поисковый робот считал, что по такому запросу пользователь скорей хочет купить товар, чем узнать информацию о нем. Но робот понаблюдал за пользователями, которые вводили этот запрос, и понял, что их чаще интересуют информационные ресурсы, а интернет-магазины они закрывают, после чего изменил интент выдачи: теперь в ТОП вышли строительные порталы, где можно почитать о том, что такое керамическая плитка, какие у нее преимущества, свойства, для чего она подходит, чем лучше аналогов и т. д.

Это тоже нормально, так выдача становится более качественной для пользователя. В таком случае не нужно пытаться что-то изменить на странице каталога, чтобы вернуть релевантность. Имеет смысл поработать над блогом интернет-магазина, чтобы охватить еще и информационные запросы. Отследить изменение структуры можно по снимкам выдачи при помощи инструмента «История по запросу» от MegaIndex.

Часть запросов просела с ТОП-10 до ТОП-50

Если сайт просел по определенным запросам на 10−50 пунктов, то нужно серьезно поработать с on-page оптимизацией:

Проблема с посадочной

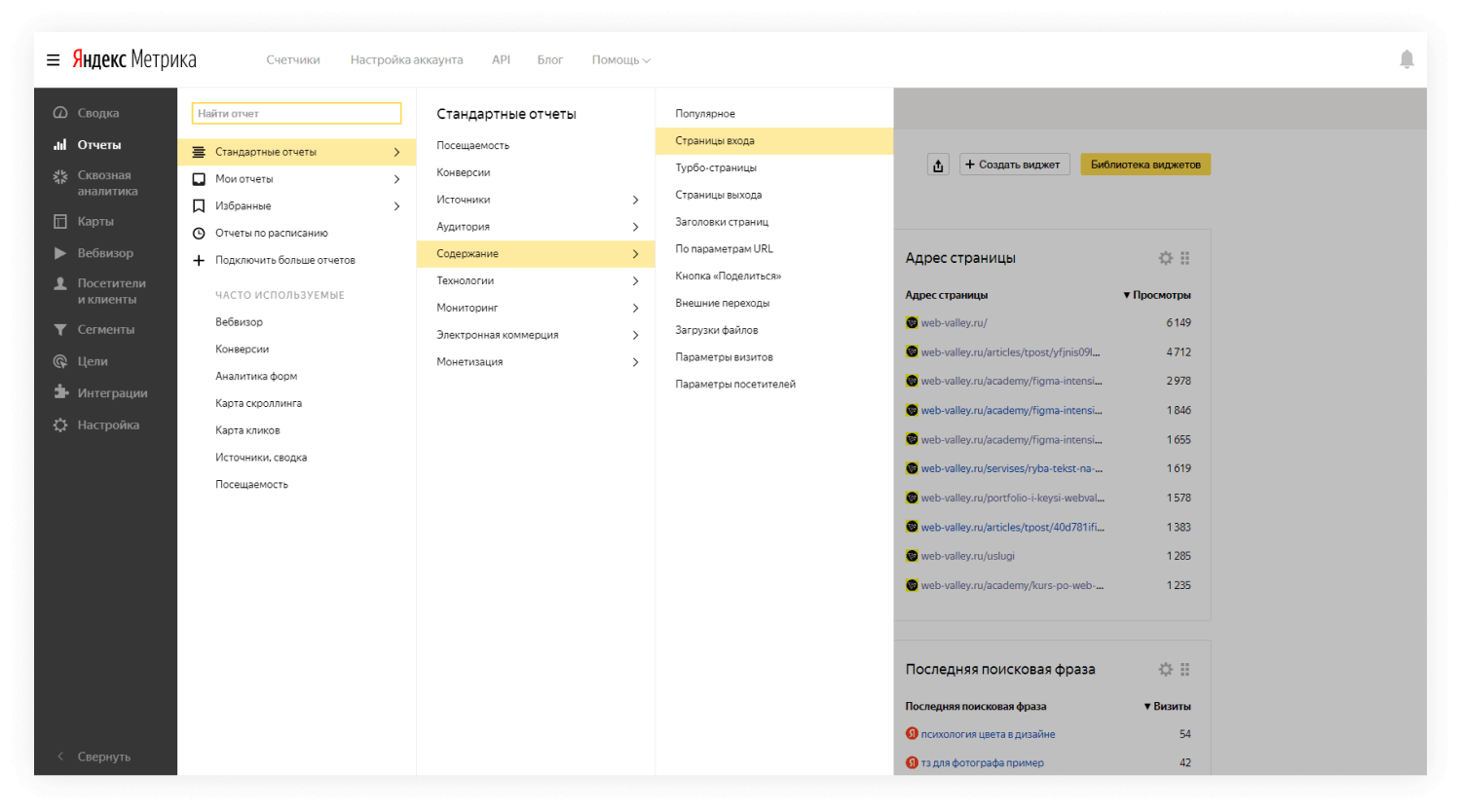

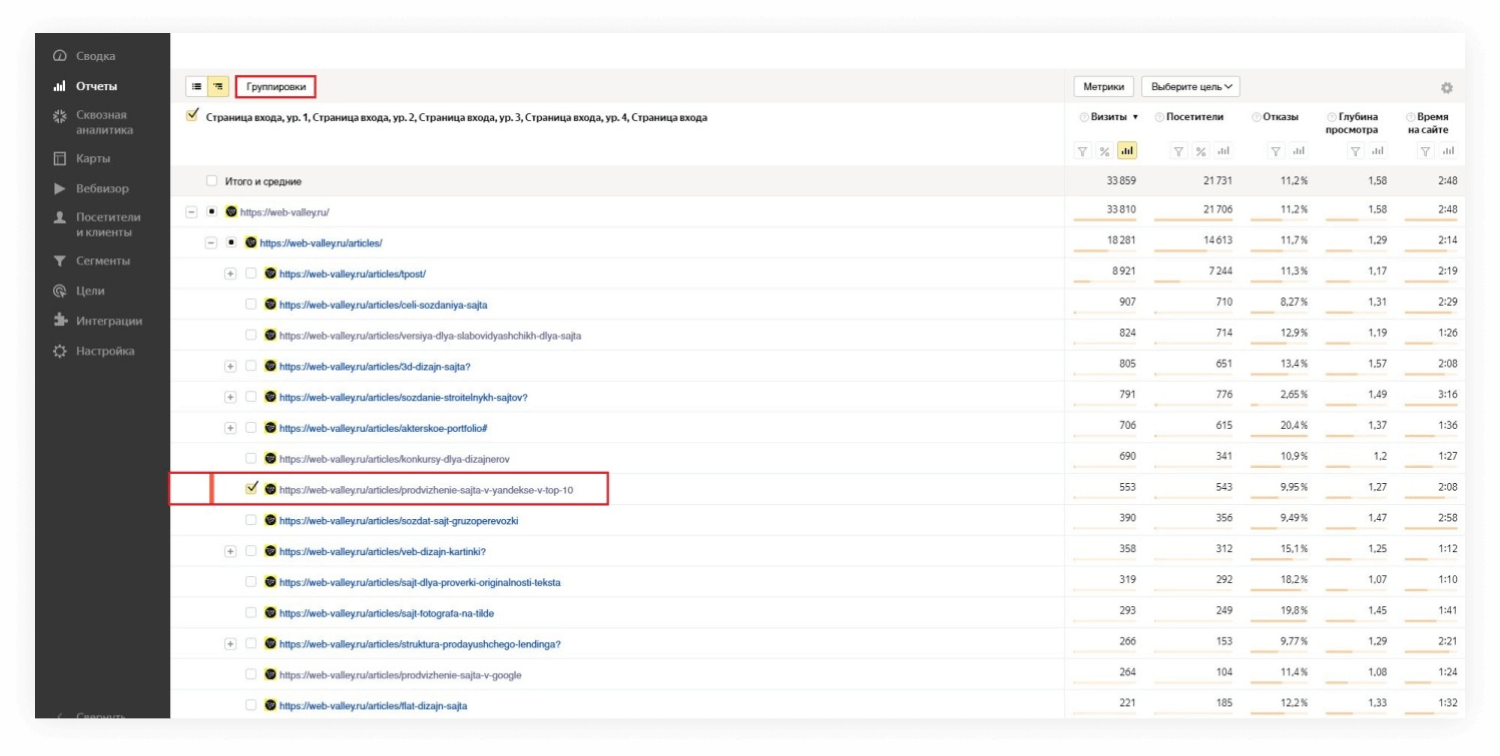

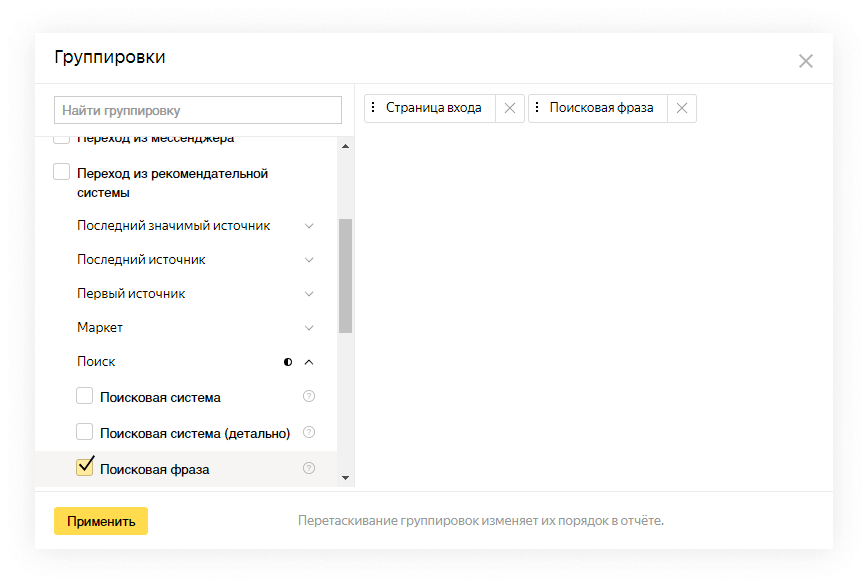

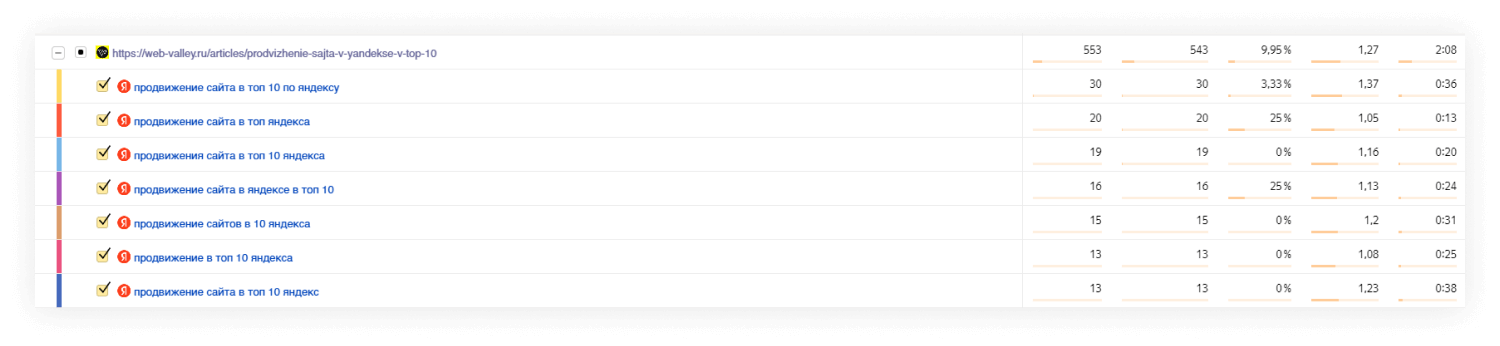

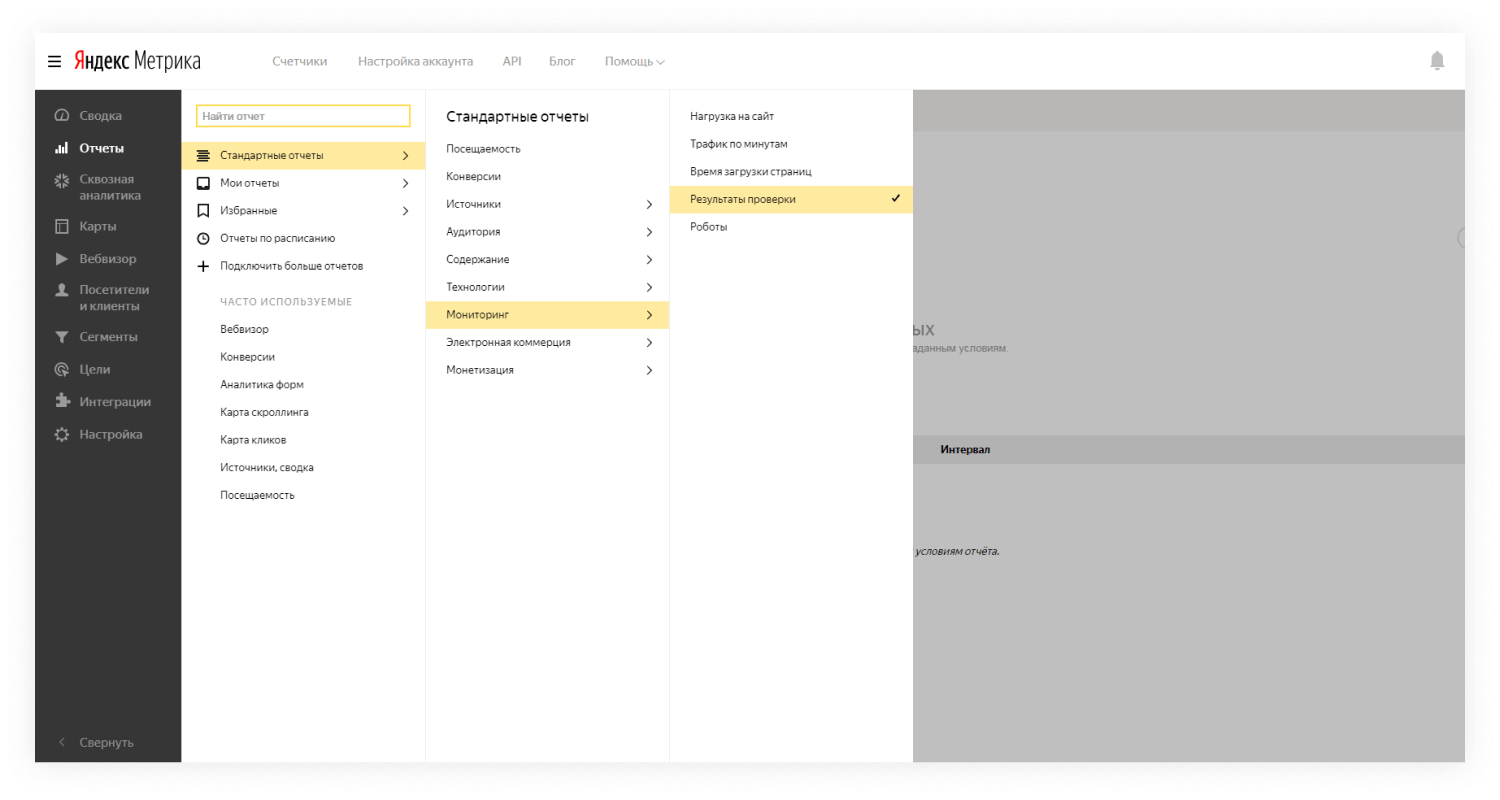

Упали запросы конкретных страниц, остальные по-прежнему в ТОПе. При помощи Яндекс Метрики сопоставим просевшие запросы со страницами, чтобы выявить закономерности и заодно проверить, все ли запросы этой страницы пострадали или часть ключей, по которым она ранжировалась все еще остались в ТОПе:

После того, как мы выявили проблемные страницы, проверяем их внутреннюю оптимизацию — техническую и семантическую. Смотрим код ответа сервера, правильно ли проставлен тег canonical, нет ли дублей, нет ли переспама в тексте.

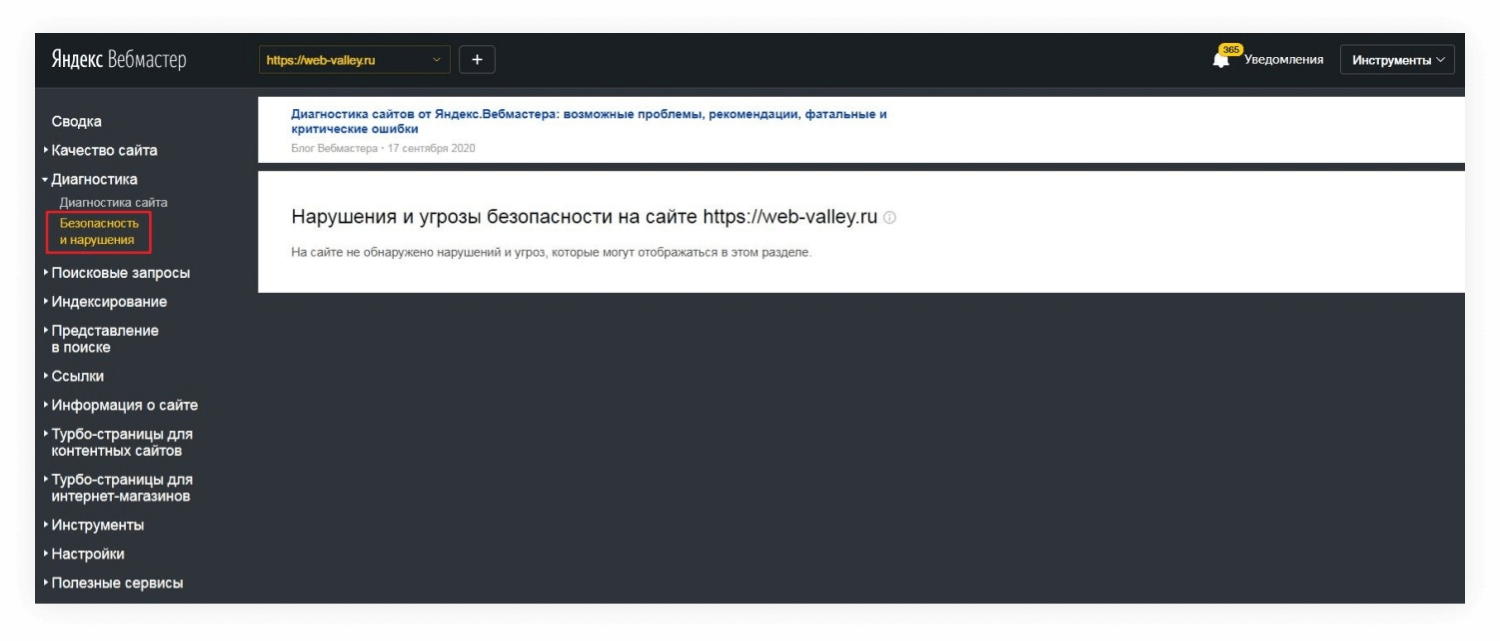

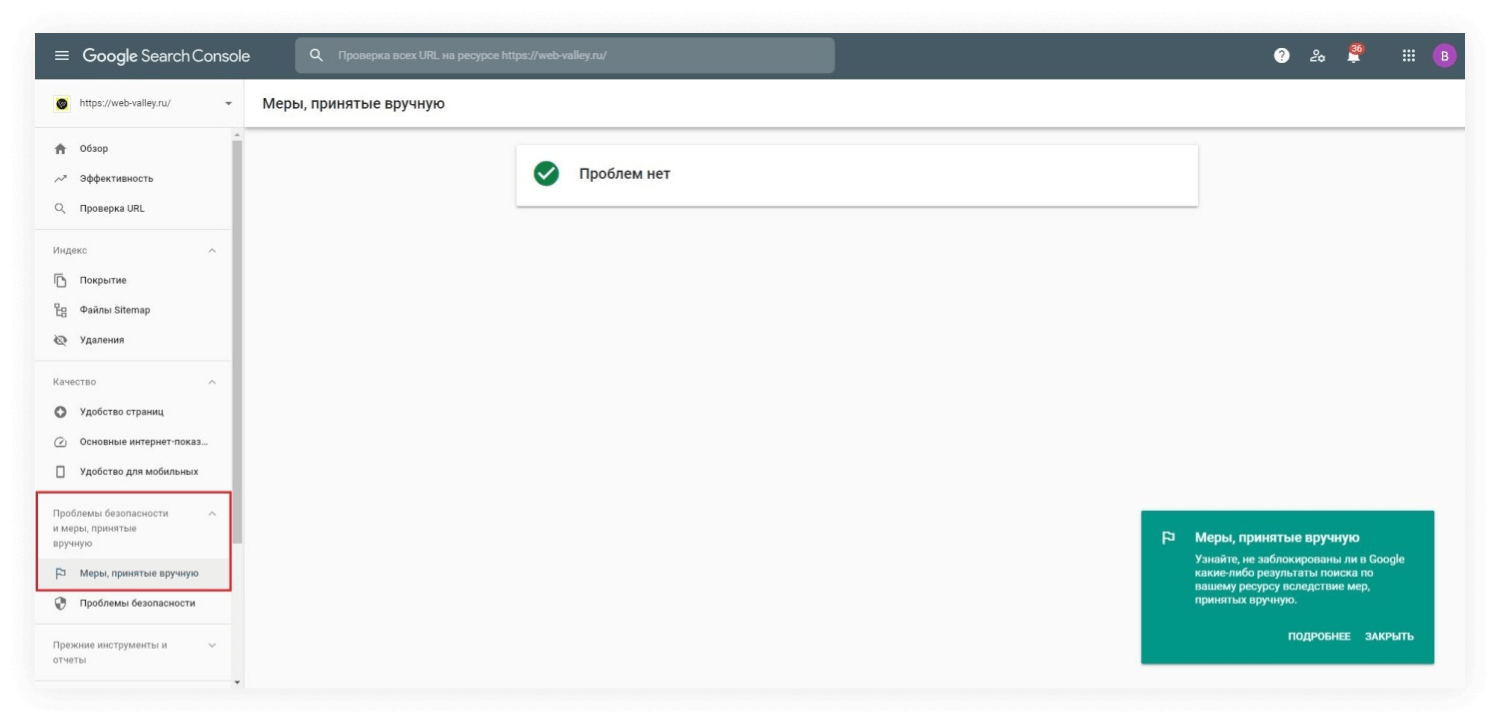

Баден-Баден

Если на предыдущем этапе, мы выявили, что просели не все запросы, по которым ранжировалась конкретная страница, а только часть, то вероятнее всего мы столкнулись с фильтром Баден-Баден, а именно с самой неприятной его разновидностью — позапросной. Отследить хостовый Баден-Баден, при котором просаживается весь сайт — не сложно, о нем сообщит Яндекс Вебмастер в разделе «Безопасность» и нарушения. Диагностировать позапросный Баден-Баден гораздо труднее: никаких уведомлений нет, поддержка фильтры не подтверждает.

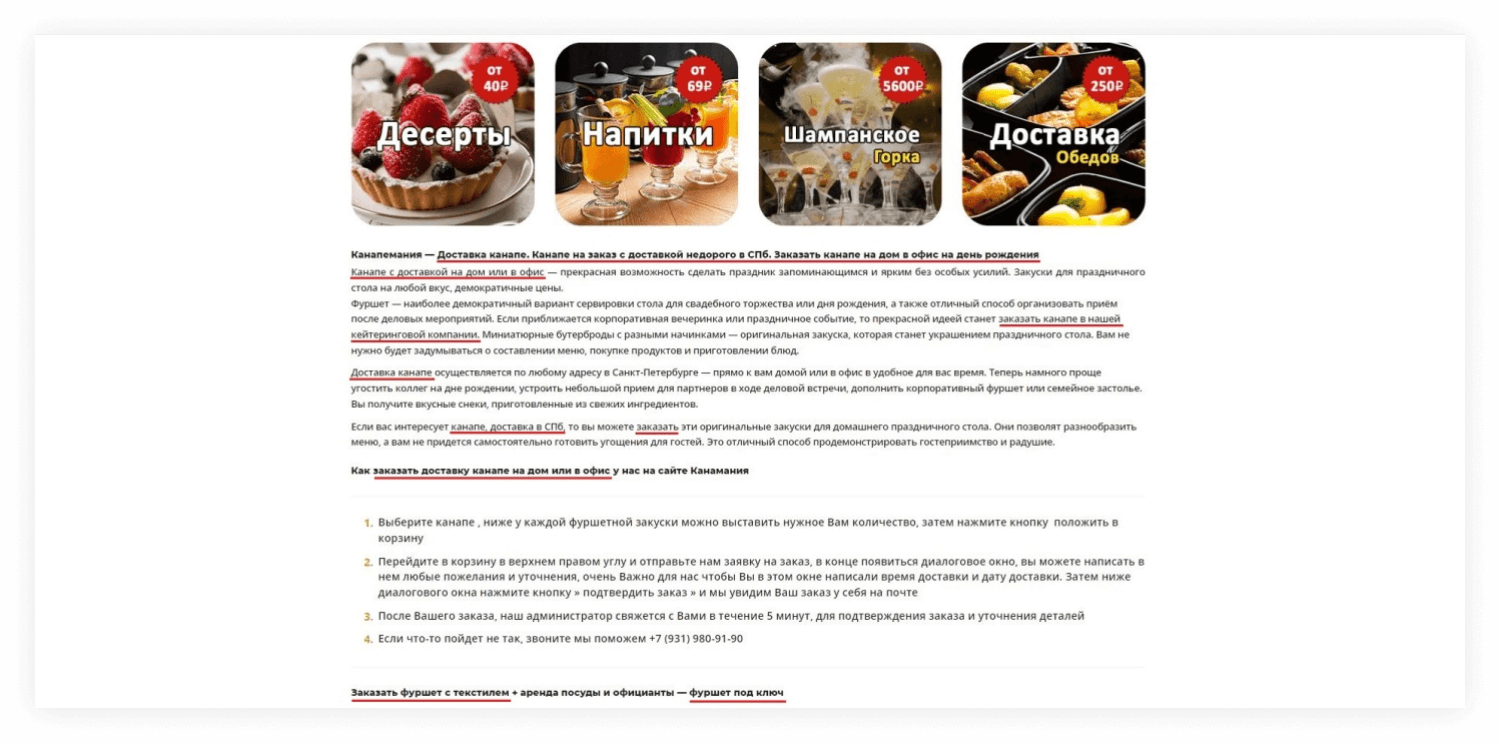

В такой ситуации работаем над текстом: чистим от переспама, неестественных вхождений ключей, спамных выделений, отжимаем воду, оцениваем полезность текста. Иногда проще переписать текст с нуля:

Проверка метатегов

Вспомните, не меняли ли в последнее время метатеги: внедрили разметку, прописали новое УТП, придумали новый Description, чтобы увеличить кликабельность сниппета — если да, откатываем.

Обсудить проект →

Все запросы просели с ТОП-10 до ТОП-50

Упал весь сайт. Видимость по запросам еще сохраняется, но на первой странице в поиске нас уже нет.

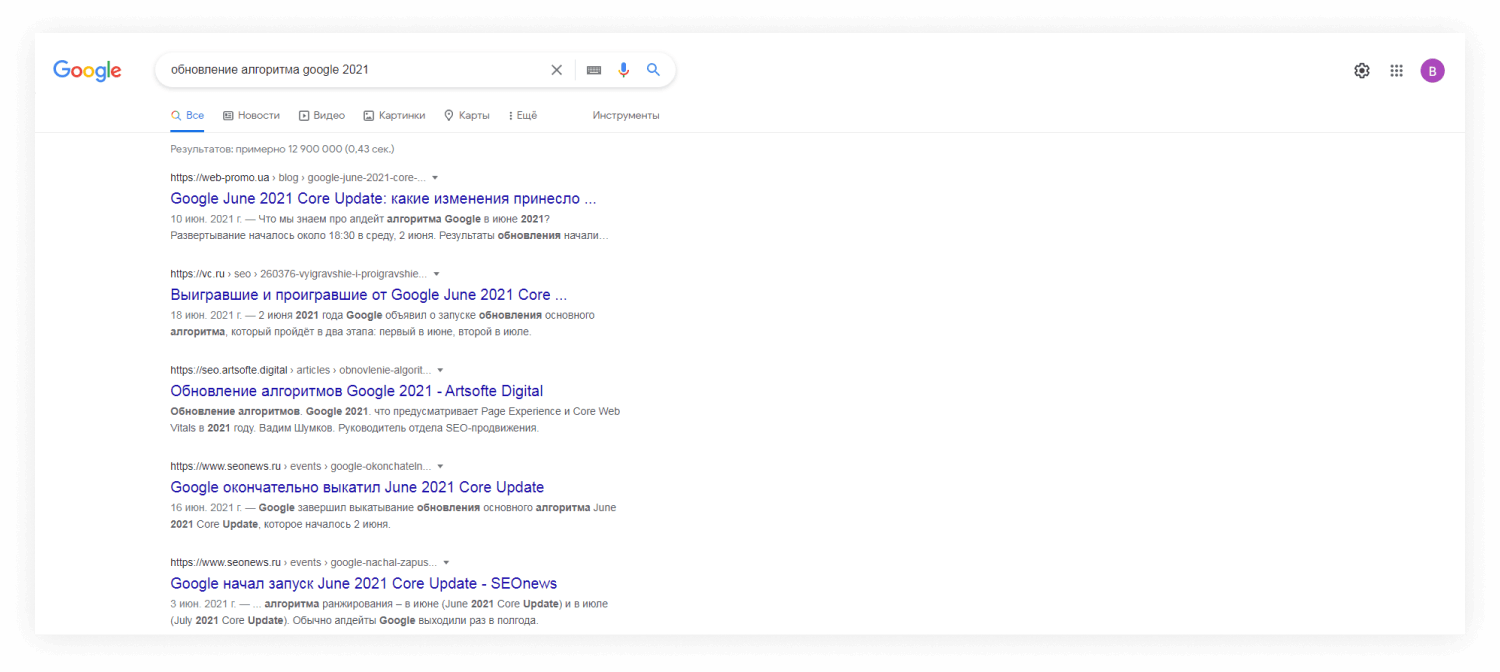

Смена алгоритма

Наиболее вероятно, что поисковая система начала по-новому ранжировать сайты. Те факторы, которые имели больший вес ранее, перестали иметь значение. Проверяем, не было ли официальных сообщений от Яндекс и Google об этом, а также анализируем снимки выдачи: если сменился весь ТОП, а не только наш сайт вылетел из десятки лучших, то однозначно мы имеем дело со сменой алгоритма.

Черное SEO

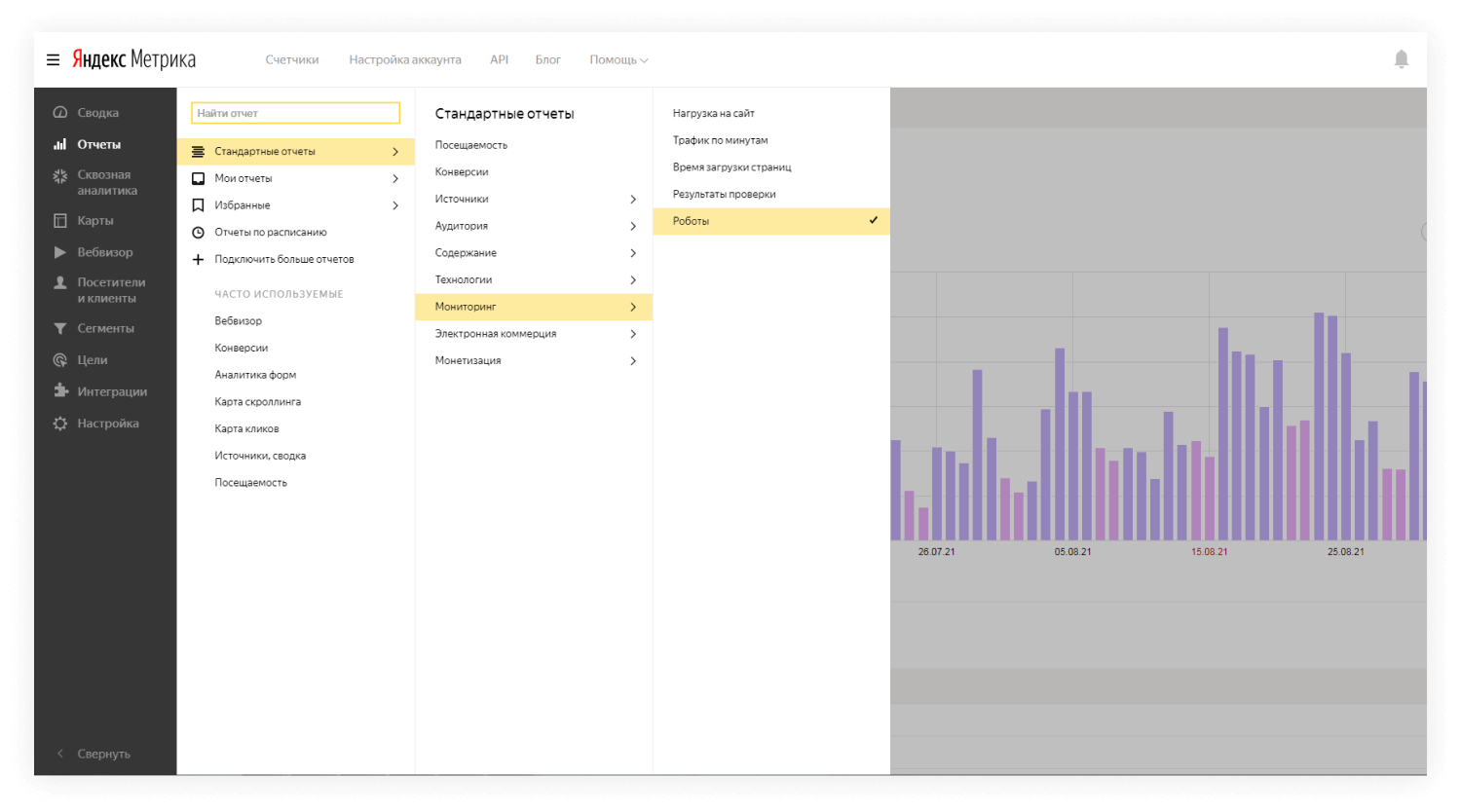

Серьезная просадка на уровне всего сайта происходит при использовании черных методов оптимизации, чаще всего — накрутки поведенческого фактора. Даже если вы сами ничем подобным не занимались, накрутку могли заказать ваши конкуренты. Поэтому обратите внимание на то, сколько ботов посещали ваш сайт и был ли аномальный всплеск посещений с плохими поведенческими метриками.

Некачественные ссылки

Резкая просадка всех страниц сайта — одно из проявлений фильтров Минусинск (Яндекс) и Пингвин (Google).

Выгрузите через Яндекс Вебмастер или Google Search Console и проанализируйте ссылочную массу:

- Какая динамика? Нет ли аномальных подъемов и спадов?

- Уделите внимание анкор-листу: сколько на ваш сайт ведет анкорных (зашитых в ключевые слова в тексте) и безанкорных (вида https://web-valley.ru/) ссылок? Нет ли перекоса в сторону анкорных? Нет ли анкоров, которые вообще не имеют отношения к деятельности вашей компании?

- С каких ресурсов размещены ссылки? Нет ли там некачественных площадок: порно-сайтов, казино, заспамленных ресурсов с низким трастом?

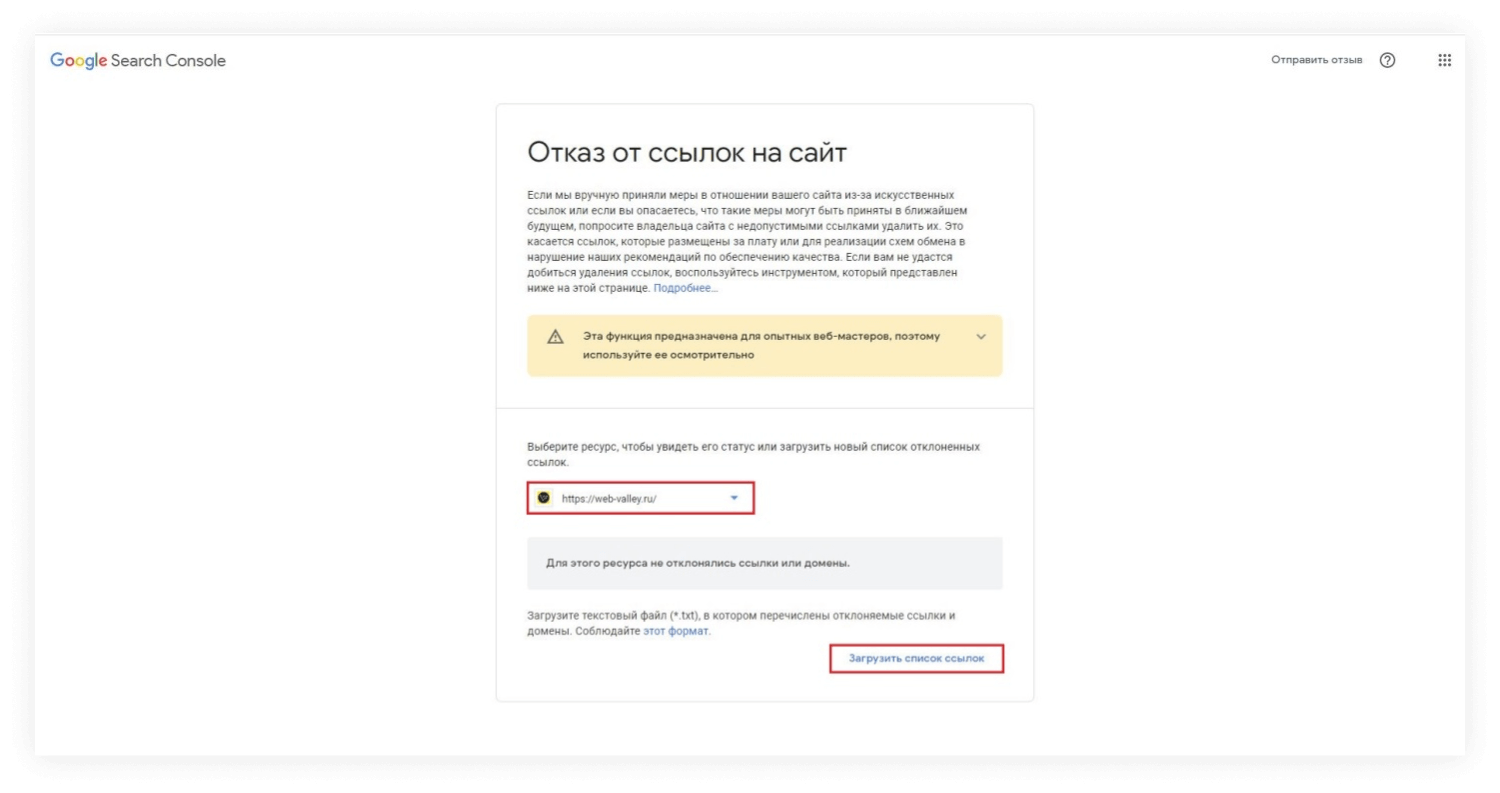

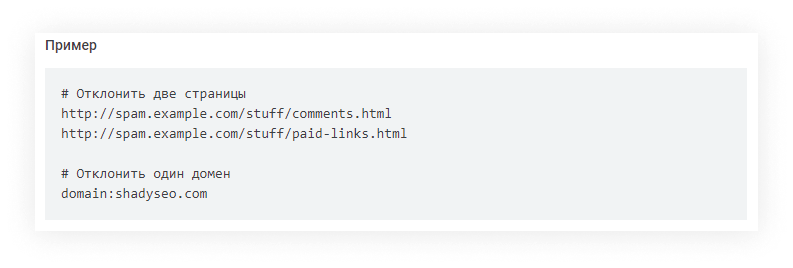

Если в ходе проверки обнаружены ссылки низкого качества, к которым вы не имеете отношения, нужно постараться снять их, написав владельцам площадок. В Google это можно сделать проще — воспользовавшись инструментом «Отказ от ссылок на сайт»:

Выбираем адрес сайта, в правильном формате заполняем текстовый файл с перечнем ссылок, которые хотим отклонить, и оставляем заявку на удаление. Конечно, Google не удалит эти ссылки с чужих сайтов, но при ранжировании учитывать их не будет.

Проблемы технической оптимизации

Прогоните сайт через сервисы аудита, Screaming Frog SEO Spider или SiteAnalyzer, чтобы выявить технические ошибки.

Обратите внимание на битые ссылки, если их много, то переходя по ним, робот постоянно попадает на страницу 404, делает вывод о некачественности ресурса и просаживает его в выдаче:

Проверьте, склеены ли зеркала — если ошибка в этом, в поисковую выдачу попадают 2 версии одного и того же сайта с незначительными различиями в URL (например, с www и без). Поисковый робот воспринимает это как попытку манипулирования поисковой выдачей, и просаживает оба зеркала.

Следите за скоростью загрузки, этот фактор ранжирования стал особенно важен после July 2021 Update от Google. В какой-то момент навешивание дополнительных скриптов начинает настолько нагружать сайт, что сервер уже не справляется, нужно переносить сайт на более мощный.

Анализируем проиндексированные страницы — не попал ли в индекс какой-то мусор: технические страницы, дубли, страницы без контента, с рыба-текстом, или находящиеся в разработке. Их нужно срочно скрыть от индексации через файл robots. txt или при помощи тега noindex, после чего принудительно удалить из индекса, не дожидаясь, пока их переобойдет поисковый робот.

Неуникальный или некачественный контент

Еще одна проблема, по которой мог просесть сайт — неоригинальный контент. Вы скопировали чьи-то тексты целиком или сделали рерайт, рассказали то, что уже обмусолили на десятках сайтах, не привнесли ничего нового, экспертного, не раскрыли проблему с другой стороны, не привели доказательства.

Сюда же относится устаревший контент — на сайте много неактуальной информации, которая уже не соответствует действительности. Поэтому нужно работать не только над новыми страницами сайта, но и актуализировать старые, чтобы робот со временем не счел их некачественными.

Бывает и такое, что владелец сайта не использовал чужие тексты, а наоборот, у него украли контент:

- Он связался с недобросовестным копирайтером, который перепродал этот текст кому-то еще;

- Изначально купил текст, не удостоверившись в его уникальности;

- Конкуренты увидели, что мы опубликовали текст на нашем сайте, успели быстро скопировать его, разместить у себя и отправить страницу на переобход раньше, чем мы, так что робот засчитал сайт конкурента за первоисточник.

В таких случаях, вы конечно можете побороться за свои исключительные права в суде, но для поискового робота это не будет иметь значение. Остается только переписывать эти статьи до нужного процента уникальности, и впредь оправлять новые страницы на переобход сразу после публикации, удостоверившись в оригинальности контента.

Часть запросов просела в ноль

Серьезная просадка трафика — наши основные запросы, с которых шел поток посетителей, не ранжируются в поиске вообще, вылетели за ТОП-100.

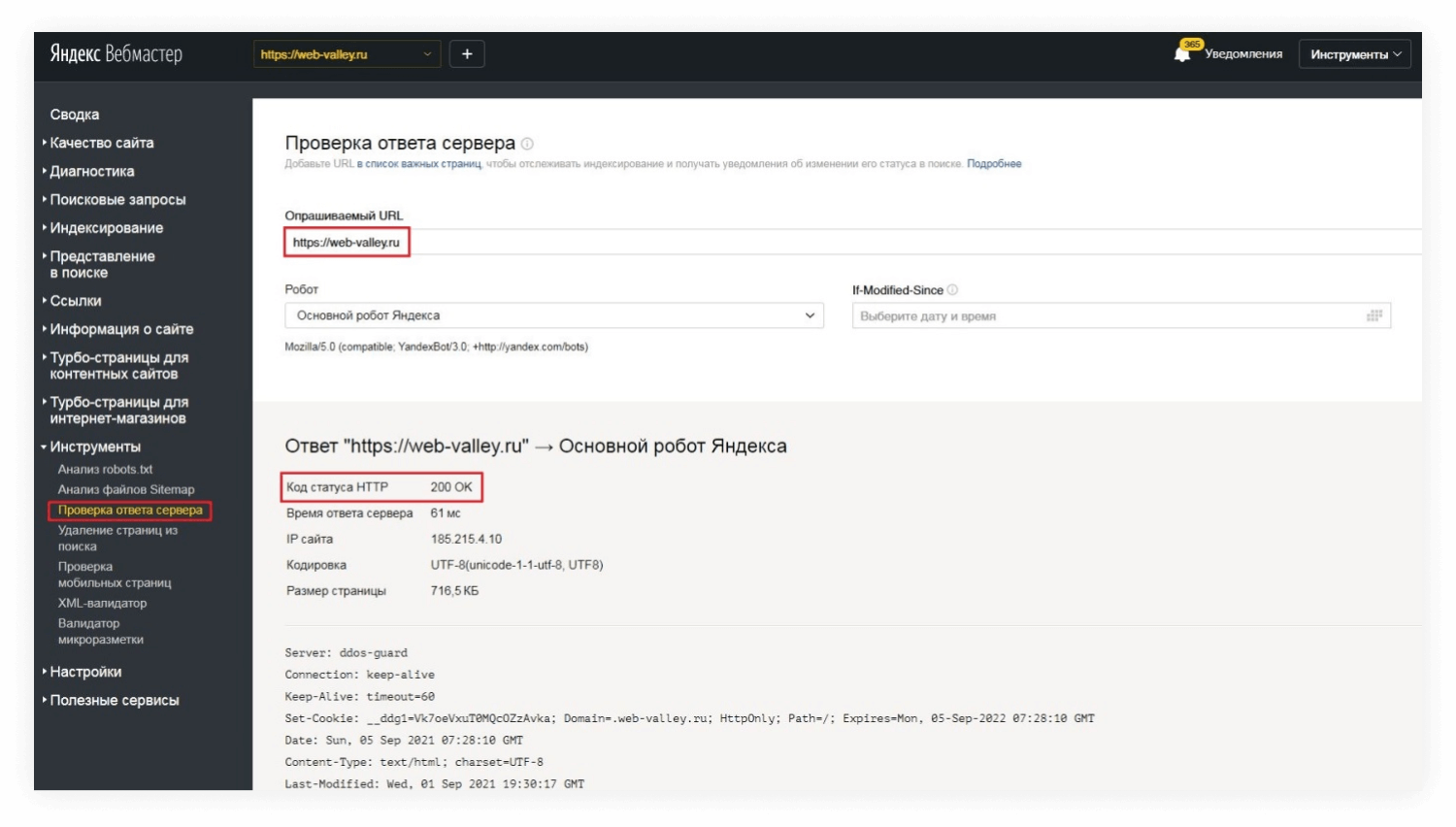

Проблемы с доступностью сервера

Первое, что нужно проверить, код ответа сервера. Он должен отдавать код 200, что означает успешную обработку, либо 301 — постоянный редирект.

Если интересующие нас страницы отдают коды 4xx или 5xx — для робота это критическая ошибка и повод удалить такие страницы из индекса.

Решаем вопросы с доступностью страницы, а после отправляем ее на переобход. Скорей всего после этого позиции восстановятся.

Обычно ошибки 403, 404, 410 удается победить самостоятельно, просто проверив, не удалена ли страница, не изменили ли мы ее адрес, забыв о редиректе.

В случае с ошибками 500, 503, 504 — обратиться в техподдержку хостинга, так как ошибки этого класса указывают на проблемы на стороне сервера.

Если мы не сразу заметили просадку, а к моменту, когда пошли проверять код ответа, ошибки на стороне сервера устранены, и мы видим, что страницы уже отдают код 200, то это повод посмотреть в Метрике, не случалось ли в последние дни даунтаймов, не было ли проблем с доступностью сервера, потому что есть вероятность, что хостер уже все починил, но робот еще не обошел упавшие страницы:

Дубли страниц

Важно избегать дублирования контента не только относительно других сайтов в поиске, но и в рамках страниц своего сайта. Если при расклеенных зеркалах происходит технический дубль всех страниц сайта, то при дублировании контента из поиска будут выпадать отдельные конкретные страницы.

В особенности эта ошибка касается интернет-магазинов, у которых есть похожие товары, различающиеся, например, только цветом, и имеющие одинаковое описание. Поисковый робот выбрасывает такие страницы из индекса с отметкой «Дубль».

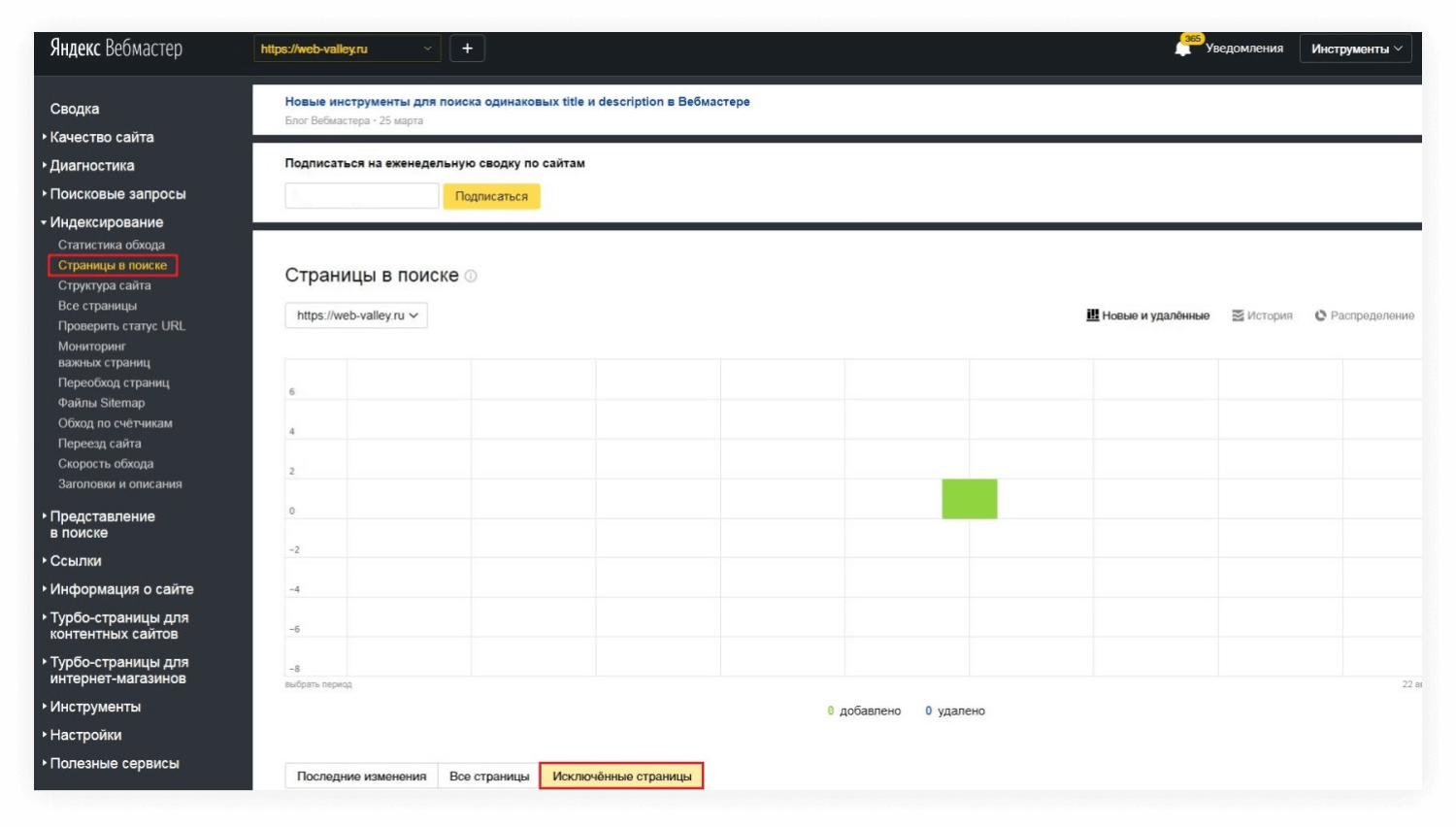

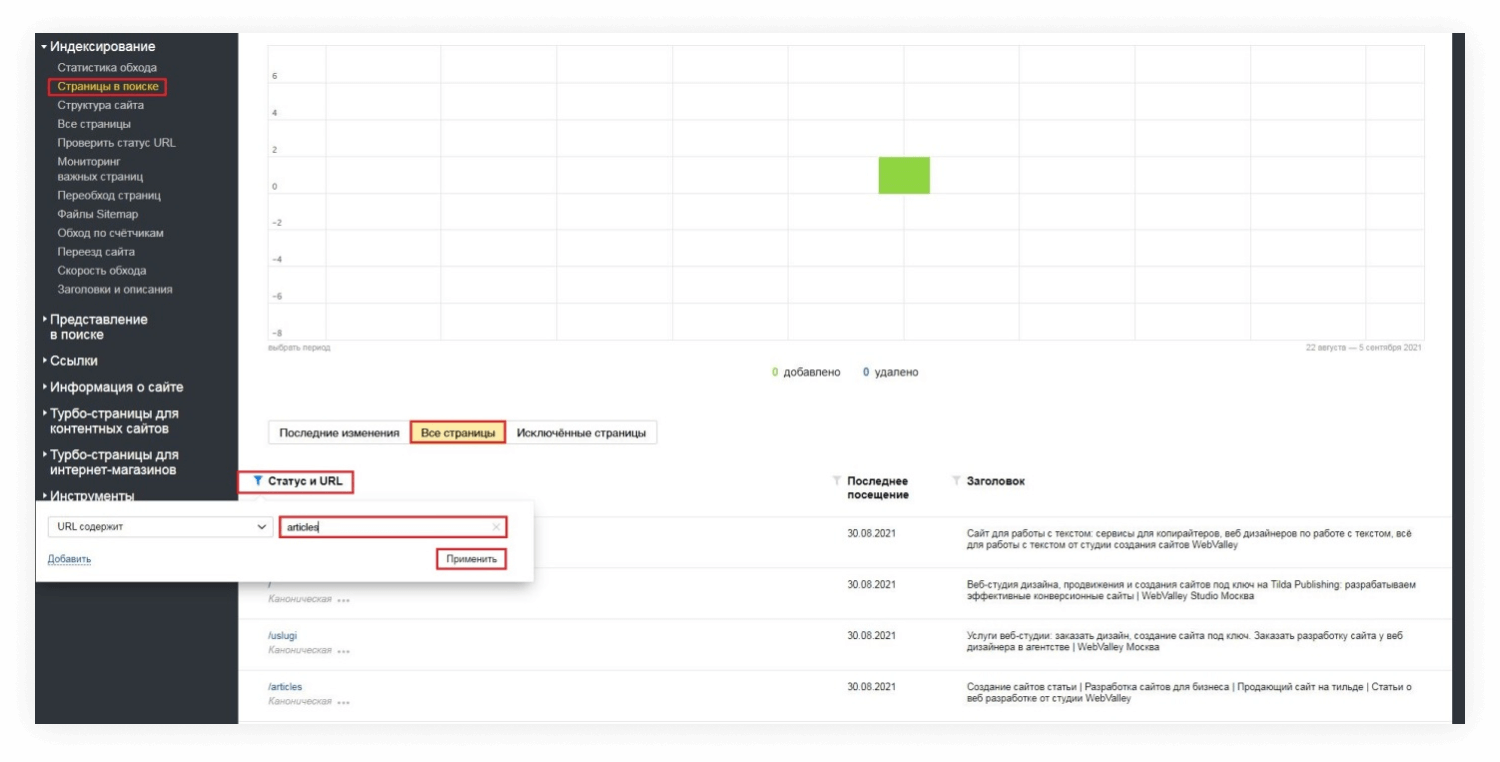

Чтобы их обнаружить, воспользуемся инструментами Яндекс Вебмастер: в левом боковом меню выбираем вкладку «Индексирование», в выпадающем списке находим «Страницы в поиске», в табах нажимаем «Исключенные страницы», в открывшемся списке просматриваем все с отметками «Дубль» или «Неканоническая»:

Чтобы вернуть их в индекс и восстановить позиции, нужно либо уникализировать контент на них, либо назначить одну из них канонической, а остальные подклеить к ней через тег canonical.

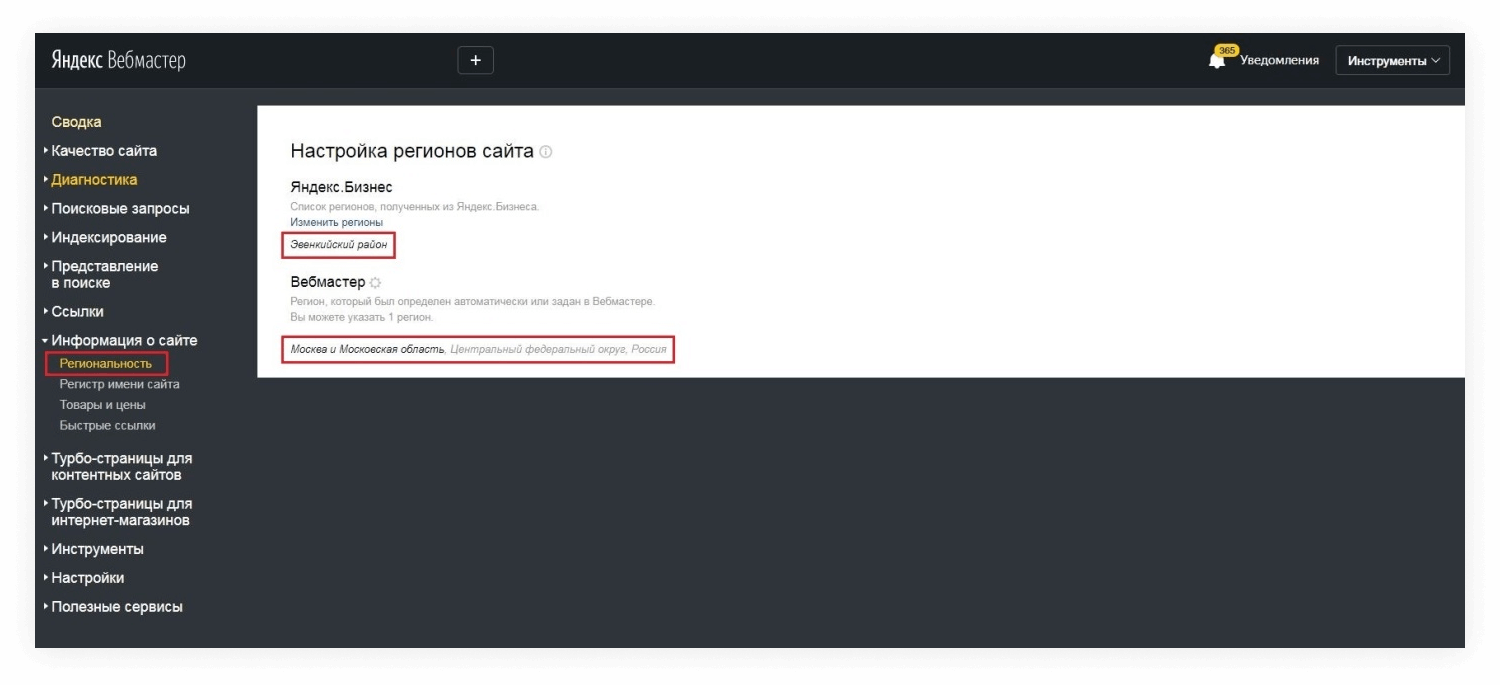

Смена региональности

Неочевидная, но возможная причина просадки — смена региональности сайта. Это могло произойти вследствие технической ошибки, или автоматически после добавления филиалов в Справочник Яндекс Бизнес. В этом случае, кажется, что страницы просели в ноль, но на самом деле они ранжируются, просто уже не в том регионе, по которому мы снимаем позиции:

Закрытие от индексации

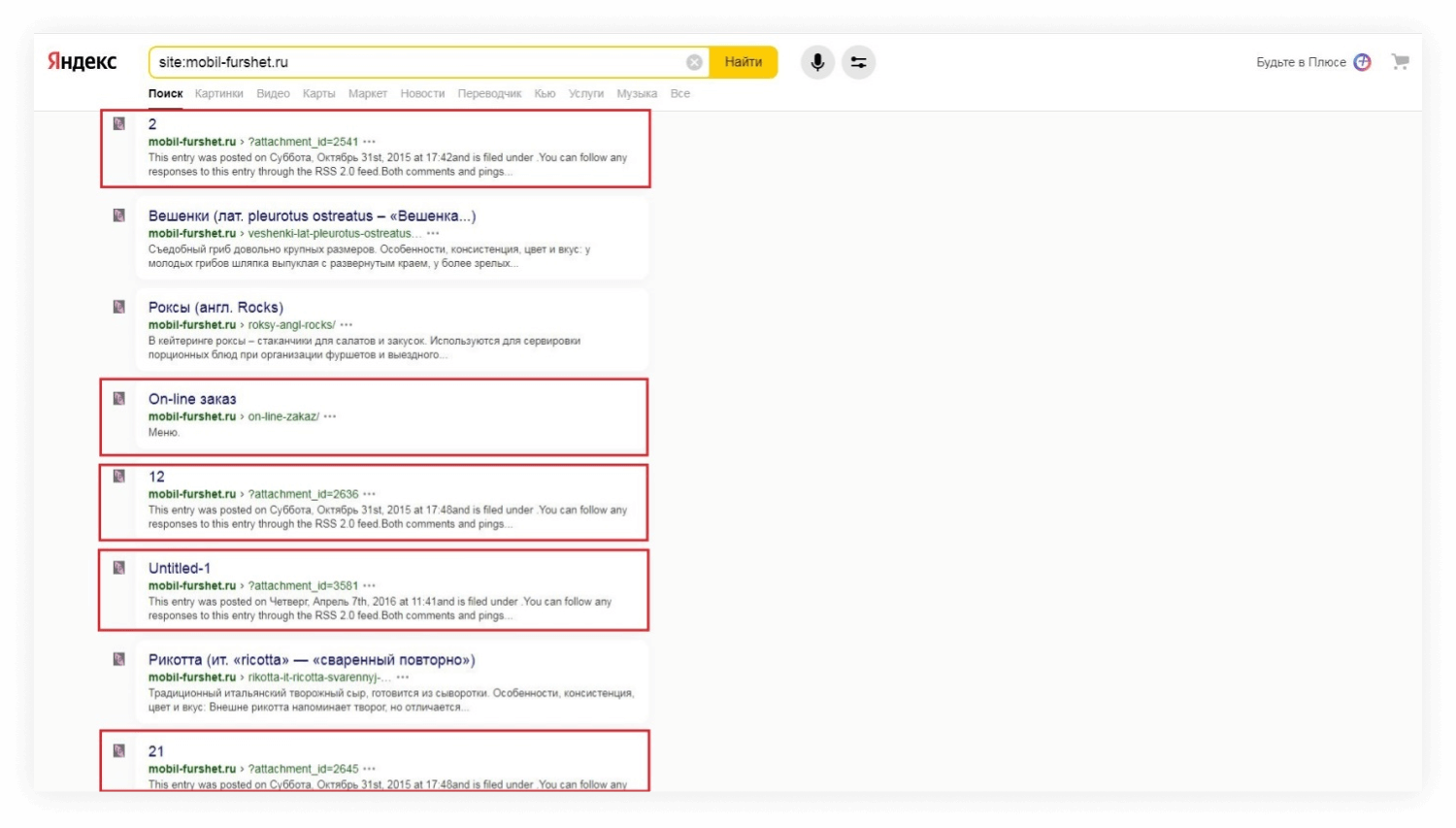

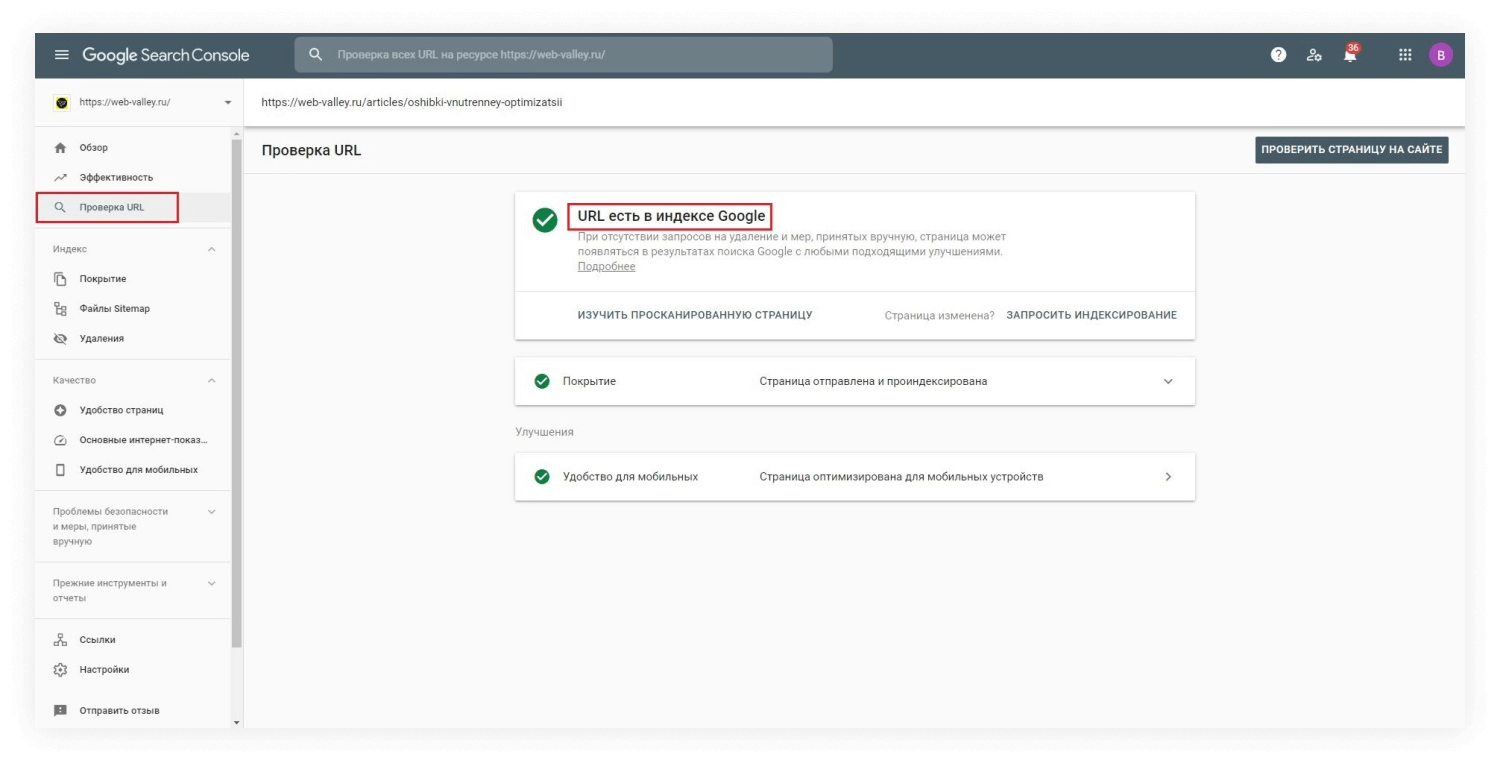

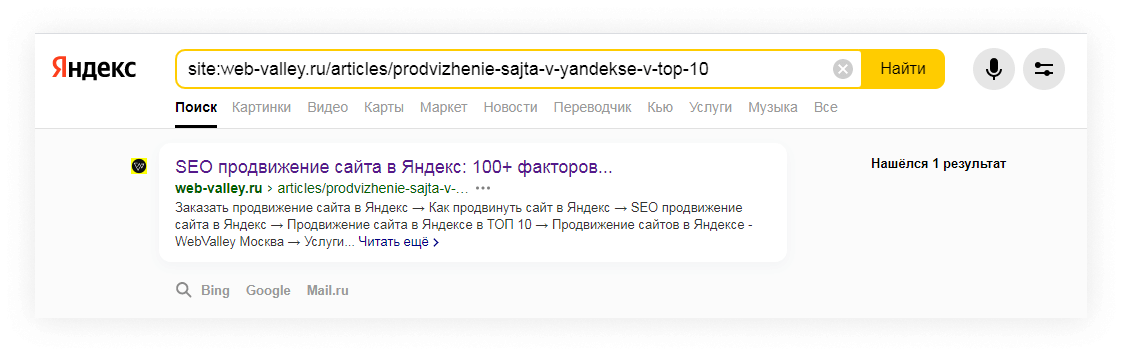

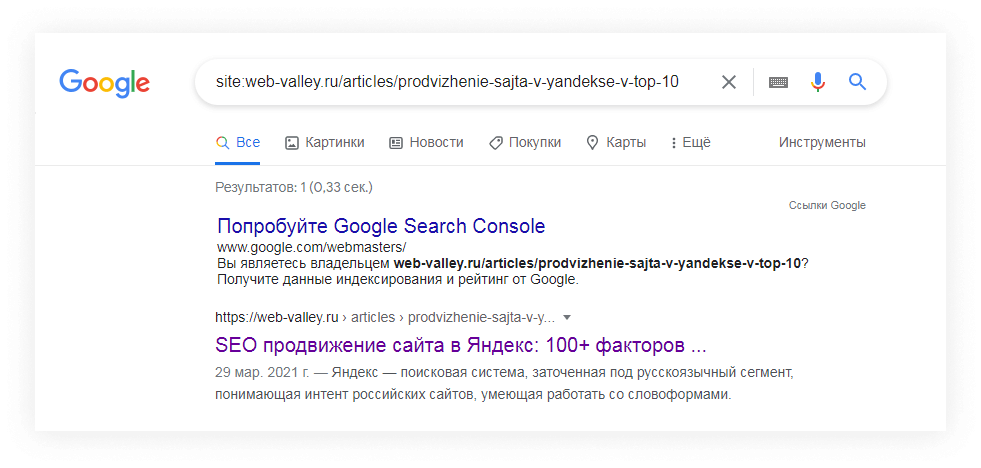

Проверьте, в индексе ли упавшая страница. Это можно сделать при помощи Яндекс Вебмастер и Google Search Console:

Либо при помощи оператора site в поисковой строке:

Убедитесь, что страница не закрыта от индексации в файле robots. txt или через тег noindex, отправьте на переобход.

Редизайн или серьезные изменения на сайте

Сайт может частично и даже полностью выпасть из индекса, если при редизайне не были правильно настроены редиректы, не сохранены метатеги, важный контент, ссылки.

Может оказаться, что ради нового дизайна, вы снесли важный SEO-текст, который добавлял релевантности странице, переделали структуру так, что сменилась вложенность страниц, перераспределился их внутренний вес, или какие-то разделы сайта исчезли полностью, объединившись с другими.

Чтобы сделать редизайн без вреда для SEO следуйте нашему чек-листу.

Весь сайт упал в ноль

Страшный сон любого владельца сайта. Все позиции, отвоевываемые годами вылетели за пределы ТОП-100. Сайт реально найти только по витальным запросам, введя доменное имя или название бренда.

Попадание под фильтр

Вероятно, где-то перестарались с продвижением, прибегая к серым или даже черным методам SEO. Либо запрещенные способы продвижения были использованы против вас конкурентами.

Чтобы выйти из-под фильтра, нужно понять, с чем мы имеем дело. Яндекс Вебмастер и Google Search Console сообщат нам об этом:

Как правило, если просел в ноль весь сайт, то мы имеем дело не с банальным переспамом, а с серьезным фильтром, типа АГС или Панда.

Нужно быть готовыми к тому, что даже после вывода из-под фильтра, сайт больше никогда не вернет прежние позиции. Иногда бывает легче создать новый сайт и продвигать с нуля, чем пытаться поднять старый.

Технические проблемы

Речь об индексации и кодах ответа сервера, только не на уровне отдельной страницы, а на уровне всего сайта.

Проверьте, не закрыт ли сайт от индексации. Возможно, это было сделано для проведения каких-то технических работ, а потом его забыли открыть.

Упавший сервер и отвалившийся домен делают сайт недоступным как для пользователей, так и для поискового робота. Если такая проблема не решается оперативно, робот удаляет все страницы сайта из индекса.

Частные случаи просадки позиций

Мы рассмотрели основные причины просадки сайтов и способы восстановления позиций. Но есть несколько частных случаев, на которые тоже нужно обратить внимание.

Позиции упали только в одной поисковой системе

Если трафик и позиции просели только в одной поисковой системе, а в другой мы по-прежнему в ТОПе, то однозначно сайт под фильтром. Несмотря на схожие принципы фильтров Яндекс и Google, они имеют разные алгоритмы, и вероятность, что выстрелит бан сразу от обеих поисковых систем, практически нулевая.

Если же видимость пропала в обеих ПС, то это больше похоже на технические неполадки на сайте или сервере.

Просадка сайта из-за неправильного переезда

Сайт может полностью потерять позиции при неаккуратном переезде на новый домен. Если вы не подготовили карту редиректов, не настроили постоянное перенаправление на новые страницы, не сохранили метатеги, или использовали JavaScript-редирект, можно забыть обо всех позициях, отвоеванных на старом домене.

Но даже если вы все сделали правильно, просадка позиций сайта при переносе на другой домен — это нормально. Они восстановятся через пару месяцев, когда поисковый робот окончательно склеит страницы.

Подробнее о том, как переехать на новый домен и не просадить SEO, читайте в нашем блоге.

Многорукий бандит

У вас новый сайт, и вы видите, что он уже в ТОПе? Не спешите радоваться. Скорее всего, он попал под алгоритм «Многорукий бандит». Благодаря «бандиту», робот примешивает на первую страницу поиска к старым лидерам новые сайты — как бы дает им шанс проявить себя. Если пользователи оценят сайт, покажут хороший поведенческий фактор, а робот увидит, что над ресурсом работают, стабильно наполняют его качественным контентом, то есть большая вероятность, что сайт закрепится в ТОПе. Но если ничего такого не произойдет, то «бандит» также быстро выставит сайт за пределы ТОПа, как и включил в него.

Поэтому, в случае с новым сайтом, рано говорить о том, что «У меня просели позиции, сайт выпал из ТОПа». Скорей всего он был в ТОПе только по воле «Многорукого бандита».

Как сохранять позиции сайта долгие годы

Никто не застрахован от смены алгоритма, пересмотра факторов ранжирования, или выхода в сеть сильного конкурента, но благодаря постоянной работе над качеством сайта можно добиться его прочного закрепления в ТОПе.

Мы рекомендуем:

- Добавлять на сайт новый контент, чтобы охватывать больше поисковых запросов, расширять семантическое ядро сайта;

- Актуализировать старые страницы, следить за тем, чтобы на сайте не было недействительной информации;

- Работать над поведенческими факторами, писать экспертные тексты, закрывающие боли, чтобы пользователи их дочитывали до конца и дольше оставались на странице, настраивать грамотную перелинковку, чтобы увеличить глубину просмотра, добавлять интерактивные элементы (слайдеры, блоки до/после, квизы), чтобы сделать взаимодействие со страницей более активным;

- Следить за ссылочной массой, вовремя чистить сайт от некачественных ссылок, соблюдать плавный постепенный рост, без резких скачков и падений количества ссылок;

- Отслеживать изменения поисковых алгоритмов, чтобы быть к ним готовым;

- Каждый месяц мониторить позиции сайта и трафик, а также проводить технический аудит;

- Периодически делать анализ конкурентов для выявления новых фишек, которые можно внедрить на сайт, сильных сторон, отраслевых стандартов, векторов развития;

- Нанять SEO-специалиста, который сделает все это за вас.

Посмотреть все услуги →